OpenAI o3-pro深度评测 + API Key获取指南:一文上手最新旗舰模型!

一、核心摘要:不止是升级,更是市场野心的宣言

2025年6月11日北京时间凌晨,OpenAI 再次搅动了AI江湖,正式推出了其 o3 系列的旗舰推理模型——o3-pro。这不仅仅是一次常规的产品迭代,更像是 OpenAI 对高端市场的一次精准打击。官方将其定位为“迄今为止能力最强的模型”,专为那些对可靠性要求极高的复杂任务而生,在科研、编程和数学等硬核领域大秀肌肉。

一个值得玩味的亮点是其内部的“4/4 可靠性”基准测试——一个要求模型连续四次独立尝试均能答对同一难题的严苛考验。o3-pro 的通过,无疑是 OpenAI 在为其“Pro”之名进行的最有力背书。

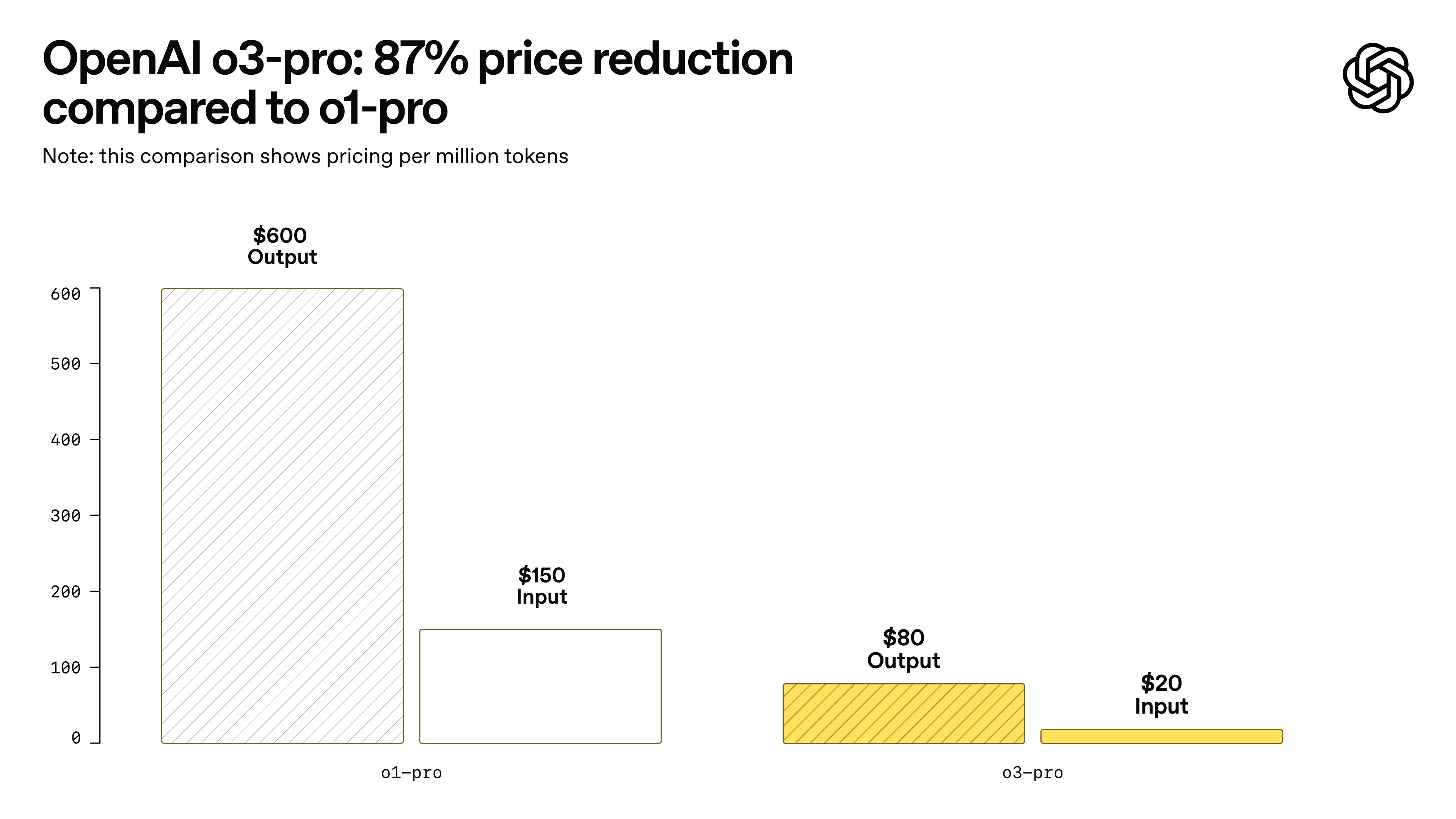

然而,好戏还在后头。在发布 o3-pro 的同时,OpenAI 挥出了一记组合拳:对基础版 o3 模型进行“史诗级”降价,同时将 o3-pro 的价格定得远低于其前代 o1-pro。这一系列操作清晰地亮出了 OpenAI 的市场野心:

- 用高性能的 o3-pro 牢牢抓住愿意为顶尖可靠性买单的高端用户。

- 用“白菜价”的 o3 大力普及先进的AI推理能力,迅速扩大用户基本盘。

这使得 o3-pro 在能力和成本效益上,对所有竞争对手都构成了直接挑战。当然,天下没有免费的午餐。o3-pro 的高可靠性是以响应速度较慢为代价的,这是一种深思熟虑后的权衡。此外,它在 ChatGPT 界面中目前还存在一些功能限制(比如不能直接画图)。

总而言之,对于那些在关键应用中,将准确性和可靠性置于速度之上的用户来说,o3-pro 提供了一个极其强大的新选择。

II. o3-pro 模型简介:一个熟悉的迭代故事

发布与迭代:速度与激情

OpenAI 在 2025 年 6月 10 日正式官宣 o3-pro,并迅速向 ChatGPT Pro、Team 用户以及 API 开发者开放。企业版和教育版用户也将在随后一周内获得访问权限。在模型选择器中,它毫不留情地取代了前代 o1-pro 的位置。

模型定位与家族谱系

o3-pro 是 o1 模型的继任者,也是基础版 o3 的“火力加强版”。官方的描述很直白:“我们最智能模型 o3 的一个版本,旨在进行更长时间的思考并提供最可靠的响应。” 这句话精准地概括了它的核心价值——为那些“值得等待几分钟”的挑战性难题而生。

一个有趣的花絮:o3 系列跳过了“o2”这个命名,据说是为了避免与移动运营商 O2 的商标冲突,这个细节也揭示了该系列项目的早期历史。

战略目标:可靠性压倒一切

推出 o3-pro 的核心目标,就是为复杂任务注入前所未有的可靠性和准确性。从科学计算到商业分析,从代码生成到学术写作,只要是对精度要求苛刻的场景,都是它的主战场。

OpenAI CEO Sam Altman 对其性能表现出了极大的信心:“它真的非常聪明!我第一次看到它相对于 o3 的胜率时,简直不敢相信。”

这延续了 OpenAI 的一种产品发布模式:先推出一个先进的基础模型(如 o1, o3),随后再发布一个“Pro”版本(如 o1-pro, o3-pro)。这些“Pro”版本通常通过投入更多的算力,来实现更强的性能和更高的可靠性,目标用户是那些愿意为顶级性能付费或接受更长等待时间的专业人士。

值得注意的是,o3-pro 取代 o1-pro 的速度非常快(o3 在4月发布,o3-pro 在6月发布),这反映了 OpenAI 顶级模型极快的迭代周期。这对于追求前沿技术的用户是好消息,但对于需要长期稳定性的企业开发者而言,也可能意味着需要更频繁地更新工作流和 API 集成,带来一定的适应挑战。

III. 核心能力与性能表现

增强的推理能力与“私有思维链”

o3-pro 的秘密武器之一,是其内在的“私有思维链” (private chain of thought) 机制。简单来说,模型在给出答案前,会先在内部进行一系列的规划和推理。这种“三思而后行”的审议式推理过程,是其解决复杂问题并提高准确性的关键。所谓“更长时间的思考”,正是这一过程的体现。

关键领域优势

在数学、科学、编程、数据分析和写作等领域,o3-pro 展现了压倒性的优势。第三方的专家评审几乎一致地更偏爱 o3-pro,而非 o3 或 o1-pro,并称赞其在清晰度、全面性、指令遵循和准确性方面的显著改进。

工具集成与多模态能力

o3-pro 继承并强化了 o3 系列强大的工具集,使其成为一个多才多艺的“瑞士军刀”:

- 网络搜索

- 文件分析

- 计算机视觉(基于视觉输入的推理)

- Python 代码执行

- 记忆功能(用于个性化响应)

这意味着 o3-pro 不仅能“思考”,还能“动手”——上网查资料、运行代码分析数据、看懂图片内容。这种模型与工具的深度融合是其强大能力的核心。

注意:API 文档中提到,网络搜索和代码解释器在 Responses API 中“不受此模型直接支持”,这可能意味着它们的调用方式与 ChatGPT 界面有所不同,或者需要通过更复杂的工具调用框架来实现。

基准测试性能:一场“神仙打架”

OpenAI 的“4/4 可靠性”基准测试

这是 o3-pro 的“毕业考试”。模型必须在连续四次尝试中都正确回答同一个问题才算通过。这项测试旨在衡量输出的一致性,而非单次表现。OpenAI 称,o3-pro 在此测试中持续优于 o1-pro 和 o3,这似乎是 OpenAI 证明“Pro”版本值得更高成本和更慢速度的核心论据。

标准学术基准测试

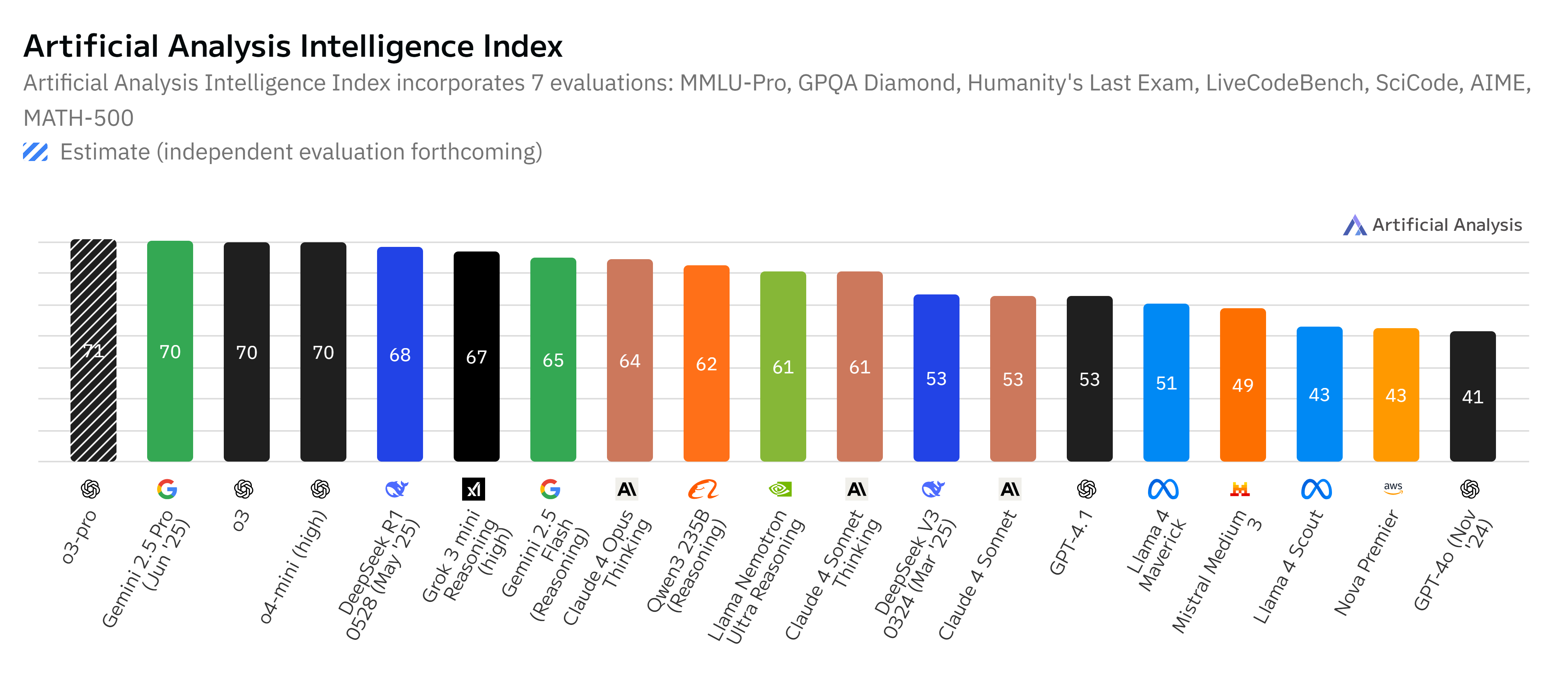

在各大公开基准测试中,o3-pro(及其基础版 o3)与 Google 的 Gemini 2.5 Pro、Anthropic 的 Claude 4 Opus 等顶级模型展开了激烈角逐。

- GPQA Diamond (博士级科学问题): o3 表现优异(约 83%-87%),有报告称 o3-pro 击败了 Claude 4 Opus。Gemini 2.5 Pro 在此也极具竞争力。

- SWE-bench (软件工程): Claude 4 Opus 在此项上表现尤为突出,略微领先于 o3。

- AIME (数学): o3 在 AIME 2024/2025 上取得高分,据称 o3-pro 在此优于 Gemini 2.5 Pro。

- MMLU (多语言问答): o3 与 Claude 4 Opus 并驾齐驱。

结论:基准测试的结果描绘了一幅“参差不齐的前沿” (jagged frontier) 图景。没有一个模型能在所有测试中完胜。o3-pro 在数学等领域表现卓越,而 Claude 在编程上可能更胜一筹,Gemini 则在某些推理基准上领先。这意味着,用户必须根据自己的具体应用场景来考察一系列相关基准,而不是迷信单一的“冠军”头衔。“最佳”模型是与任务相关的。

速度与延迟:为可靠性付出的代价

这一点 OpenAI 毫不讳言:由于需要更深度的推理和调用工具,o3-pro 的响应速度明确慢于 o1-pro 和基础 o3。官方建议在“等待几分钟也值得”的场景下使用。API 文档甚至指出,某些请求可能需要“几分钟才能完成”,并建议使用后台模式以避免超时。此外,不支持流式输出。

这种延迟是其强大能力的直接结果。模型不仅要思考“做什么”,还要思考“用什么工具”、“如何用”、“用了之后结果怎么整合”。这个过程大大扩展了其能力边界,但也引入了新的复杂性和时间成本。

IV. 技术规格

底层架构

o3-pro 建立在与 o3 模型相同的基础之上,是一个通过“增加计算量来获得更好响应”的特殊版本。其核心依然是生成式预训练 Transformer (GPT) 模型,并通过强化学习对思维链推理进行了深度训练。

上下文窗口与输出限制

- 上下文窗口: 200,000 tokens,与 Claude 4 Opus 等竞品处于同一水平。

- 最大输出: 100,000 tokens。

知识截止日期

- 2024 年 5 月 31 日。这是一个相对较新的日期,对于需要最新信息的任务非常有用。

API 详情

- 可用性: 仅在 Responses API 中可用。这是一个更适合处理多轮交互和复杂工具调用的高级 API。

- 推理令牌 (Reasoning Tokens): 这是模型内部“思考”过程消耗的令牌,会计入输出令牌数量并占用上下文窗口。OpenAI 建议至少为推理和输出预留 25,000 个令牌。

- 后台模式: 支持,用于避免长时间运行的请求超时。

- 流式输出: 不支持。这是一个显著特点,影响实时交互体验。

- 微调 (Fine-tuning): 不支持。

解读:

- 高昂的“思考成本”: 200k 的上下文窗口虽大,但大量的“推理令牌”消耗意味着实际可用的空间会小很多。开发者必须仔细估算这种隐性成本。

- 不适合实时应用: 不支持流式输出,意味着 o3-pro 不适合那些需要即时、增量反馈的聊天机器人或实时协作工具。

- 有限的定制化: 不支持微调,限制了其在需要深度定制化的企业解决方案中的应用。

表 1: OpenAI o3-pro - 关键技术规格和 API 详情

| 特性 | 详情 |

|---|---|

| 模型名称 (版本) | o3-pro (例如, o3-pro-2025-06-10) |

| 底层基础模型 | o3 |

| 上下文窗口 | 200,000 令牌 |

| 最大输出令牌 | 100,000 令牌 |

| 知识截止日期 | 2024 年 5 月 31 日 |

| API 可用性 | 仅限 Responses API |

| 支持的输入模态 (API) | 文本, 图像 |

| 支持的输出模态 (API) | 文本 |

| 流式输出支持 (API) | 不支持 |

| 微调支持 (API) | 不支持 |

| 关键支持工具 (API) | 文件搜索, 图像生成 (通过工具调用)。网络搜索和代码解释器在 Responses API 中列为“不受此模型直接支持”。 |

| 推理令牌计费 | 作为输出令牌计费 |

Export to Sheets

V. API 访问与定价结构:一场精心策划的价格战

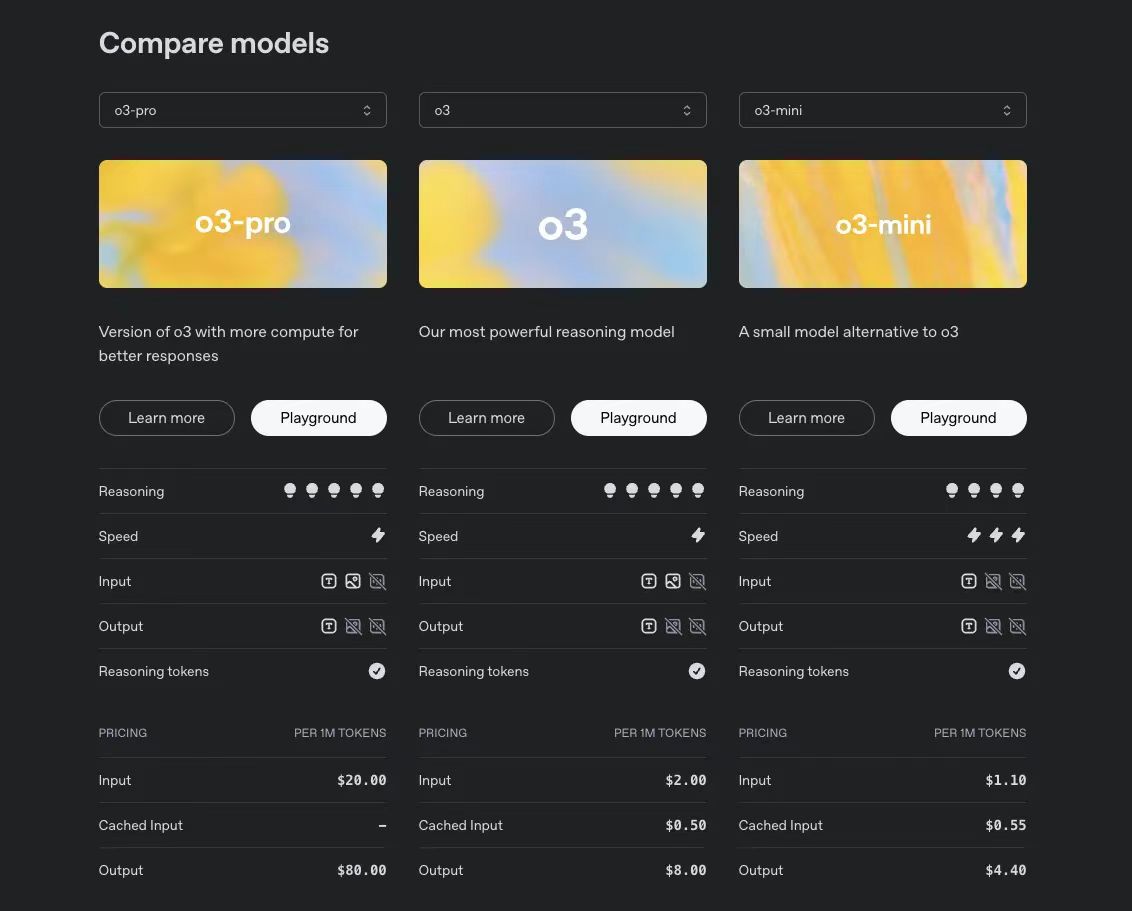

一、API 定价

- 输入: $20 / 百万令牌

- 输出: $80 / 百万令牌

这比其前代 o1-pro **便宜了 87%**,对于顶级模型而言,降价幅度堪称“革命性”。输出价格是输入的 4 倍,也反映了生成和推理所需的高昂计算成本。

以下是更为精简OpenAI o3 系列模型 API Key 获取与激活流程操作说明:

二、通过 OpenAI 官方渠道获取 API Key

登录并访问 API Keys 页面

登录 OpenAI 账户,进入 API Keys 管理页面,创建新的 API Key。设置账单

添加有效支付方式,确保已启用账单功能,否则无法正常调用 API。(如需)完成组织验证

若需使用 o3 系列模型或部分高级功能,按页面指引完成组织验证。确认模型权限

在仪表板相关菜单(如 “Limits” 或 “API Usage”)检查目标模型是否已激活访问权限。保存 API Key

生成后请妥善保存 API Key,避免泄露。

三、国内通过AI模型的云服务获取 API Key

注册并登录UIUIAPI云服务平台

选择国内支持 OpenAI 接口的云服务,完成注册和登录。获取 API Token

在**“uiuiapi.com”**平台控制台生成 API Token。使用兼容接口

按平台说明调用兼容 OpenAI 的 API 接口(https://sg.uiuiapi.com/v1/chat/completions),支持 o3、o3-mini、o4-mini 等模型。

与 o3 (基础版) 定价比较

- 基础 o3 模型价格下调 80%,降至 $2 (输入) / $8 (输出) 每百万令牌。

- 这意味着 o3-pro 的价格是基础 o3 的整整 10 倍。

解读:清晰的市场分层

OpenAI 的定价策略极其清晰:

- o3 (基础版): 成为一个极易获得的、高性价比的先进推理模型,足以挑战甚至在价格上击败 Gemini 2.5 Pro 等竞争对手。

- o3-pro (专业版): 针对那些对可靠性有极致要求、且对特定任务价格不敏感的专业市场。

一个不容忽视的隐性成本:由于“推理令牌”按昂贵的输出令牌计费($80/百万),一个看似简短的答案背后,可能隐藏着数万个推理令牌的高昂“思考成本”。max_output_tokens 参数因此成为一个关键的成本控制工具,但设置过低又可能导致推理不完整。

表 2: API 定价比较 - 主要推理模型

| 模型 | 每百万输入令牌价格 ($) $ | 每百万输出令牌价格 () | 备注 |

|---|---|---|---|

| OpenAI o3-pro | 20.00 | 80.00 | 推理令牌按输出计费 |

| OpenAI o3 (基础版) | 2.00 | 8.00 | - |

| Google Gemini 2.5 Pro | 1.25 - 2.50 | 最高 15.00 | 取决于提示大小 |

| Anthropic Claude 4 Opus | ~22.50 | ~112.50 | 不同来源数据有差异;通常价格较高 |

| OpenAI o3-mini | 1.10 | 4.40 | - |

VI. 当前局限性与考量因素

ChatGPT 界面中的功能缺失

- 图像生成: 目前无法在 ChatGPT 中直接使用 o3-pro 生成图像。

- Canvas 支持: 不支持。

- 临时聊天: 因技术问题暂时禁用。

API 不支持的特性

- 流式输出、微调、蒸馏 等均不支持。

潜在的更高幻觉率?

o3 的系统卡片指出,基础 o3 模型虽然更准确,但倾向于做出更多整体性陈述,这可能导致其在某些基准(如 PersonQA)上的幻觉率高于 o1。由于 o3-pro 基于相同的底层模型,它可能继承了这种倾向,尽管其针对可靠性的优化旨在缓解此问题。一些社区讨论也提到基础 o3 比之前的模型更容易产生幻觉。

慢,是刻意的选择

o3-pro 的慢响应是其设计哲学的一部分,用户必须接受这一点。

核心考量:

- 功能差距:ChatGPT 界面和 API 之间的功能可能存在差异或分阶段推出,开发者需要仔细核对。

- 幻觉的复杂性:如果 o3-pro 产生幻觉,其复杂的推理路径可能使这些幻觉更难被发现,或更巧妙地融入看似连贯的输出中。这要求用户进行更稳健的验证。

- 避免“杀鸡用牛刀”:模型天生倾向于“长时间思考”,用它处理简单任务可能会效率低下或输出过于复杂。选择合适的模型(如 o3-mini 或 o3)至关重要。

VII. 对比分析:新王当立,旧王何在?

A. o3-pro vs. o3 (基础版):10倍价格,换来什么?

- 同源不同命: 两者共享基础模型,但 o3-pro 通过投入更多算力换取了更高的可靠性。

- 性能优势: 评测和基准测试一致表明 o3-pro 在复杂任务上优于 o3。

- 成本鸿沟: 10 倍的价格差异,让用户面临一个清晰的选择:是选择极具性价比的 o3,还是为顶级可靠性支付高昂的溢价?这突显出,在 AI 领域,推动可靠性边界的最后几步,计算成本是极其高昂的。

B. o3-pro vs. o1-pro:一场关于“智能”风格的辩论

- 迭代换代: o3-pro 在基准上全面超越并取代了 o1-pro。

- 成本革命: 87% 的降价从根本上改变了顶级推理模型的经济性,让前沿 AI 不再是少数人的昂贵玩具。

- 用户感知的风格变化: 这部分最有趣。一些资深用户(特别是学术研究者)表达了失望,认为 o3-pro 的输出是“惰性文本”(lazy text),缺乏 o1-pro 那种“准确、细微且富有创造力”的特质。

- “思考者” vs. “执行者”: 一种普遍的看法是,o1-pro 更像一个进行广泛、深入分析的“思考者”;而 o3 系列(包括 pro)则更像一个高效使用工具的“执行者”,其思考过程有时显得较为“仓促”。

解读:这暴露了基准驱动的改进与主观用户满意度之间的潜在鸿沟。“更好”是一个主观概念。o3-pro 在可靠性(基准分数、工具使用)上取得了进步,但在另一个维度(写作风格、洞察深度)上,却让一部分用户感到了退步。这可能是所谓的“对齐税” (alignment tax) 的体现——为了安全和一致性,牺牲了一部分模型的“个性”和创造力。

C. o3-pro vs. 竞争对手 (Gemini 2.5 Pro, Claude 4 Opus)

- 基准表现不一: 如前所述,这是一场“神仙打架”,每个模型在不同领域各有胜场,形成了“参差不齐的前沿阵地”。

- 定性差异:

- o3-pro: 专为极致可靠性而生,但速度慢。

- Gemini 2.5 Pro: 全能型选手,视觉能力突出,价格极具竞争力。

- Claude 4 Opus: 编程能力备受推崇,指令遵循能力强,但价格最为昂贵。

- 定价策略的影响: OpenAI 的激进定价给竞争对手带来了巨大压力。Claude 4 Opus 虽然在某些领域领先,但其高昂的价格使其难以成为通用选择。这使得 o3 甚至 o3-pro 在更广泛的场景中极具吸引力。

表 3: 关键基准性能比较(摘要)

| 基准测试 | o3-pro / o3 表现 | Gemini 2.5 Pro 表现 | Claude 4 Opus 表现 |

|---|---|---|---|

| GPQA Diamond (推理) | 强劲 (o3-pro 据称优于 Opus) | 强劲 | 强劲 |

| SWE-bench (编程) | 良好 | 中等 | 领先 |

| AIME (数学) | 领先 (o3-pro 据称优于 Gemini) | 良好 | 强劲 |

| MMLU (综合) | 领先 (与 Opus 并列) | - | 领先 (与 o3 并列) |

| AA 智能指数 | 71 (o3-pro) / 70 (o3) | 70 (Jun ‘25) | 64 (Opus Thinking) |

Export to Sheets

注:基准测试结果因各种因素而异,此表为简要总结。

VIII. 深度剖析:冰山之下的技术逻辑

“思维链”与“工具使用”:从“思考者”到“智能体”

o3-pro 将“思维链”(CoT)从一种提示技巧,内化为了模型的核心操作方式。它不仅能思考,还能主动调用工具(网络、代码、文件)来辅助思考。这标志着模型正在从一个纯粹的“语言生成器”进化为一个更复杂的“AI 智能体”(Agent)。

这带来的影响是深远的:

- 评估方式的变革: 评估这类模型,不再是看它“知道”多少,而是看它“解决问题”的能力有多强——包括它如何制定策略、选择工具、整合结果。传统的 LLM 基准已显不足。

- “约束框架”的重要性: 如何通过系统提示(System Prompt)和上下文来引导模型的行为,变得异常重要。优秀的“约束框架”能极大地释放模型的潜能,反之则可能导致混乱。

“4/4 可靠性”指标:在随机性中追求确定性

LLM 本质上是随机的,对同一输入可能产生不同输出,这对于需要稳定结果的企业应用是个噩梦。“4/4 可靠性”指标正是为了解决这一痛点。它强迫模型达到一种伪确定性状态——对于它擅长的问题,能够持续地、稳定地给出正确答案。

这与其说是衡量峰值能力,不如说是衡量能力的可靠性。虽然该基准的具体问题集不公开,使其更像一个内部标准和营销亮点,但它所代表的理念——在商业应用中建立对 AI 的信任——是极其务实的。

IX. 宏观背景与战略意义

“对齐税”:可靠性的代价是“无聊”吗?

用户抱怨 o3-pro 输出“惰性”,可能正是“对齐税”的体现。为了让模型更安全、更听话、更可靠(即“对齐”),训练过程可能会无意中削弱其输出的多样性和创造性,使其趋向于更保守、更可预测、但也可能更“无聊”的回答。这是当前 LLM 发展中一个核心的权衡。

多层模型战略:一个成熟市场的信号

OpenAI 如今拥有 o3-mini、o3、o3-pro,并正在开发 o4-mini。这种分层策略,与 Gartner 预测的企业将更多使用小型、特定任务模型的趋势不谋而合。它允许用户根据能力、速度、成本的平衡,为自己的应用场景找到最合适的工具。这标志着 AI 市场正在从“一个模型打天下”的时代,走向更加细分和成熟的阶段。

UIUIAPI. 内容结论

优势与劣势总结

- 优势: 极致的可靠性、强大的工具集成、远低于前代的价格、巨大的上下文窗口。

- 劣势: 响应速度慢、API 功能受限(无流式/微调)、可能存在“过度思考”和输出风格“乏味”的问题、推理令牌带来隐性成本。

对用户和开发者的建议

- 选对工具:

- o3-pro: 用于准确性压倒一切且能接受延迟的关键任务(如科研、代码审查、复杂数据分析)。

- o3 / o3-mini: 用于成本敏感或需要快速响应的日常任务。

- 管好成本: 密切关注“推理令牌”的消耗。

- 务实评估: 不要只看通用基准,要在自己的具体用例中进行测试,特别是关注输出的定性方面。

o3-pro 的发布,清晰地表明了最前沿的 AI 模型正在走向专业化和工具化。它不再是一个试图取悦所有人的通用聊天机器人,而是一款为解决特定高难度问题而生的高精度工具。

更具成本效益的基础模型(如 o3)将承担起日常主力军的角色,而像 o3-pro 这样的“专家”模型,则会在金字塔的顶端,解锁那些过去因风险过高而无法应用 LLM 的新场景。

这场 AI 的竞赛,已经从单纯比拼谁更“聪明”,演变为一场关于可靠性、工具化、成本效益和市场策略的立体战争。而 o3-pro,正是 OpenAI 在这场新战役中投下的一枚重磅棋子。

版权信息 本文由UIUIAPI团队编写,保留所有权利。未经授权,不得转载或用于商业用途。

暂无评论,1218人围观